- ダウンロード商品無料サンプル版 v1.2¥ 0無料ダウンロードdepth-book_v120_無料サンプル版.pdf(46.8 MB)depth-book_v120_無料サンプル版.pdf

- ダウンロード商品【50%オフ】電子書籍 v1.2(PDF)¥ 500

- 物販商品(倉庫から発送)ネコポス可能製本版+電子版セット在庫なし¥ 1,500

iOSにおける「デプス」(深度)の取り扱いについて、基礎から応用まで詳しく解説した書籍です。 A5版、本文72ページ。iOS 13, Swift 5.1, Xcode 11対応。サンプルコードはGitHubよりダウンロード可能です。

著者プロフィール

京都大学にて電気電子工学、京都大学大学院にて信号処理を学び、NTTデータにて音声処理、キヤノンにて画像処理を専門として研究開発に従事。カヤックにてiOSアプリ開発者としてフルスクラッチで30本以上のアプリを開発しリリースする。その後シリコンバレーの500Startupsのインキュベーションプログラムに参画。続いてサンフランシスコのFyusion社にてシニア・プリンシパルエンジニアとしてH-1Bビザで3年間勤務。現在は日本でフリーランスとして活動中。オープンソース活動も積極的に行い、GitHubの累計スター数は23,000超。 著書 - 『iOSエンジニアのためのmacOSアプリ開発入門』(個人出版/2019) - 『iOS 12 Programming』(PEAKS/2018) - 『実践ARKit』(個人出版/2018-2019) - 『Metal入門』(個人出版/2018-2019) - 『iOS 11 Programming』(PEAKS/2017) - 『iOS×BLE Core Bluetoothプログラミング』(ソシム/2015年) - 『iOSアプリ開発 達人のレシピ100』(秀和システム/2013年)

改訂履歴

- v1.2.0(電子版のみ)2019.10.9刊行 -- 「第4章 2D写真から3D点群を生成する」を追加。 -- 本文72ページ, iOS 13, Swift 5.1, Xcode 11対応。 - v1.1.0(第2版)2019.9.22刊行 -- 「People Occlusion」「デプス推定」「一般物体のセグメンテーション」の章を追加。 -- 本文68ページ, iOS 13, Swift 5.1, Xcode 11対応。 - v1.0.0(初版)2019.4.14刊行 -- 本文44ページ, iOS 12, Swift 5, Xcode 10対応。

目次(v1.2)

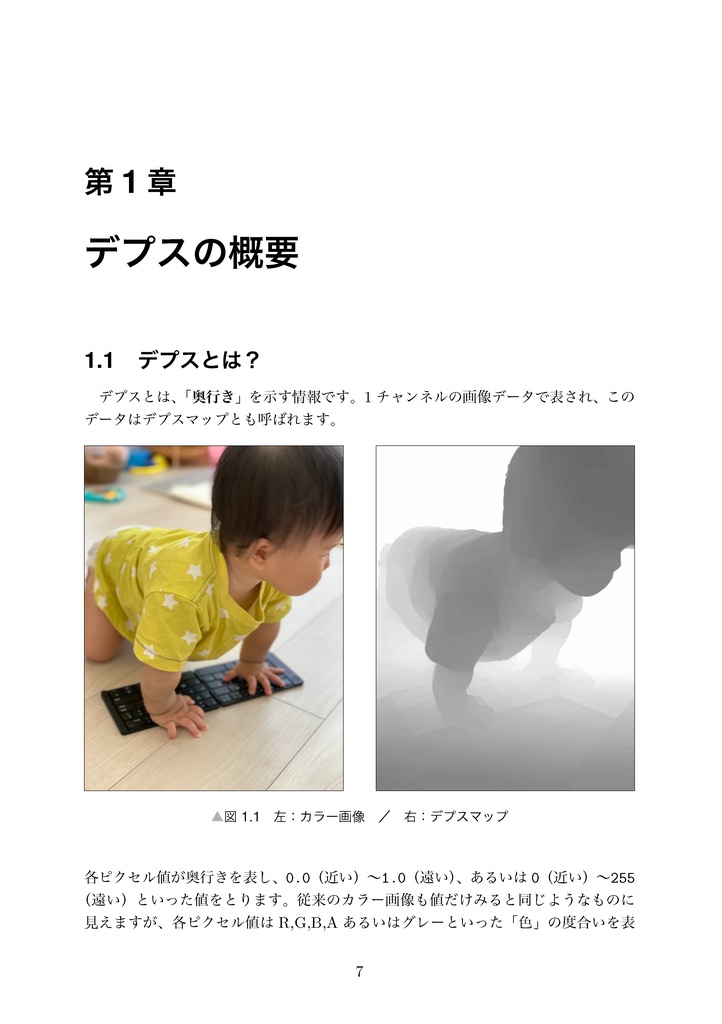

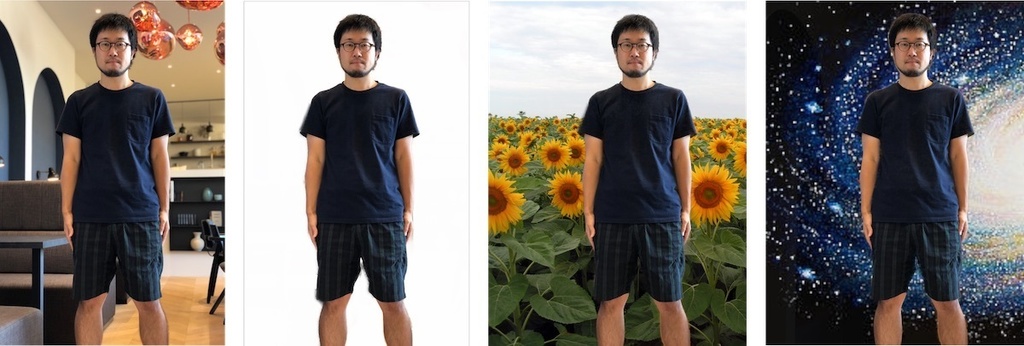

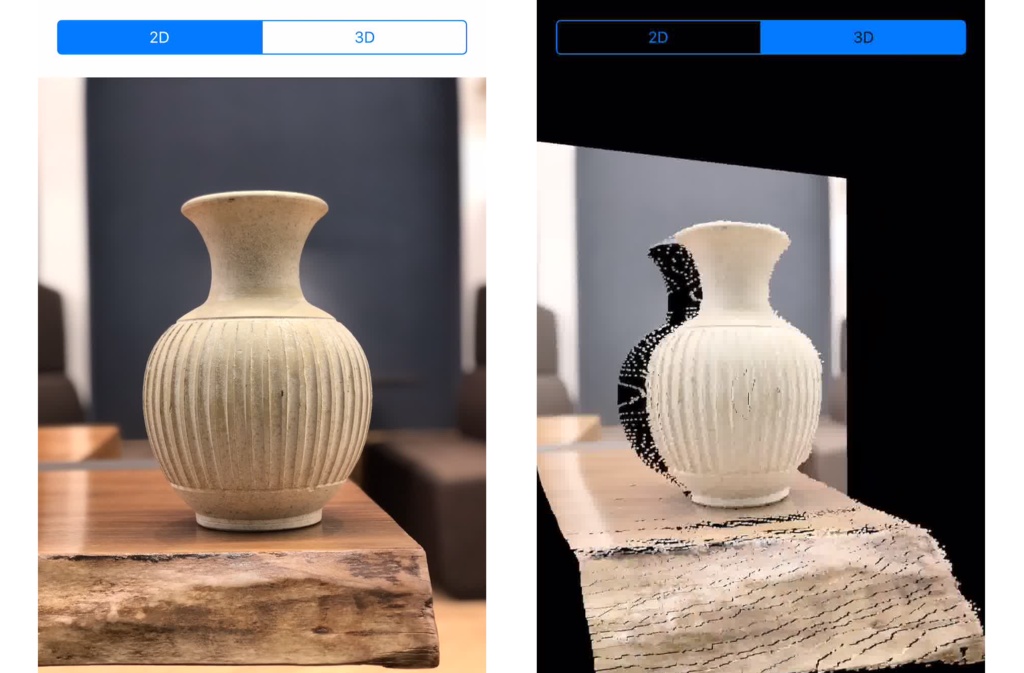

第1章 デプスの概要 - 1.1 デプスとは? - 1.2 デプスの用途 - 1.3 Disparity(視差)とDepth(深度) - 1.4 AVDepthData 第2章 iOSにおけるデプス取得方法 - 2.1 デプス取得方法1: 撮影済み写真から取得 - 2.2 デプス取得方法2: カメラからリアルタイムに取得 - 2.3 デプス取得方法3: ARKitから取得 第3章 デプス応用1: 背景合成 - 3.1 CIBlendWithMask - 3.2 デプスデータをそのままマスクとして用いる - 3.3 デプスマップを二値化する - 3.4 マスクの平滑化 第4章 デプス応用2: 2D写真から3D点群を生成する - 4.1 3D点群座標を求める計算式 - 4.2 Intrinsic Matrix - 4.3 3D点群座標計算の実装 - Intrinsic Matrixを取得する - Intrinsic Matrixをスケールする - Intrinsic Matrixを用いてX, Yを計算する 第5章 Portrait Effects Matte - 5.1 AVPortraitEffectsMatte - 5.2 Portrait Effects Matteの取得方法 - 5.3 Portrait Effects Matteの取得条件/制約 第6章 Semantic Segmentation Matte - 6.1 Semantic Segmentation Matteの取得方法 - 6.2 AVSemanticSegmentationMatte - 6.3 SSMをCIImage経由で取得する 第7章 People Occlusion (ARKit) - 7.1 PeopleOcclusionの実装方法 - 7.2 personSegmentationとpersonSegmentationWithDepth の違い - 7.3 利用可能なコンフィギュレーション - 7.4 segmentationBufferとestimatedDepthData - 7.5 Metalカスタムレンダリング時のオクルージョン - ARMatteGenerator - オクルージョン処理のMetalシェーダ 第8章 デプス推定 - 8.1 FCRN-DepthPredictionモデル - 8.2 デプス推定モデルを使用する 第9章 一般物体のセグメンテーション - 9.1 iOSにおける他のセグメンテーション手段との違い - 9.2 DeeplabV3を利用したリアルタイムセグメンテーションの実装

目次(v1.1)

第1章 デプスの概要 - 1.1 デプスとは? - 1.2 デプスの用途 - 1.3 Disparity(視差)とDepth(深度) - 1.4 AVDepthData 第2章 iOSにおけるデプス取得方法 - 2.1 デプス取得方法1: 撮影済み写真から取得 - 2.2 デプス取得方法2: カメラからリアルタイムに取得 - 2.3 デプス取得方法3: ARKitから取得 第3章 デプス応用 - 3.1 応用1: 背景合成 - 3.2 応用2: 2D写真を3D空間に描画する 第4章 Portrait Effects Matte - 4.1 AVPortraitEffectsMatte - 4.2 Portrait Effects Matteの取得方法 - 4.3 Portrait Effects Matteの取得条件/制約 第5章 Semantic Segmentation Matte - 5.1 Semantic Segmentation Matteの取得方法 - 5.2 AVSemanticSegmentationMatte - 5.3 SSMをCIImage経由で取得する 第6章 People Occlusion (ARKit) - 6.1 PeopleOcclusionの実装方法 - 6.2 personSegmentation と personSegmentationWithDepth の違い - 6.3 利用可能なコンフィギュレーション - 6.4 segmentationBufferとestimatedDepthData - 6.5 Metalカスタムレンダリング時のオクルージョン - ARMatteGenerator - オクルージョン処理のMetalシェーダ 第7章 デプス推定 - 7.1 FCRN-DepthPredictionモデル - 7.2 デプス推定モデルを使用する 第8章 一般物体のセグメンテーション - 8.1 iOSにおける他のセグメンテーション手段との違い - 8.2 DeeplabV3を利用したリアルタイムセグメンテーションの実装